Los culpables de todo esto

El otro día viendo Cosmos me percaté de que de casi cualquier ciencia hasta el más neófito conoce a unos cuantos de los nombres más famosos. Pongamos que hablamos de física: rápidamente se nos viene a la cabeza Einstein, por ejemplo. O Newton, o Galileo, o Aristóteles si hace falta. Si hablamos de química pensamos en Marie Curie y si hablamos de biología enseguida pensaremos en Darwin o en Linneo. Ahora bien, ¿y si hablamos de informática?

Aquellos ajenos a las entrañas de la computación es posible que sean capaces de nombrar a Bill Gates o a Steve Jobs, que aunque fueron bastante importantes a la hora de la popularización y (sobre todo) de la domesticación de la informática, no fueron precisamente sus padres. La informática, como ciencia que estudia el tratamiento automático de la información (de ahí el término), es algo bastante viejo. Todo lo que vemos hoy día tiene raíz en algo que lleva décadas siendo estudiado o incluso implementado. Sin ir más lejos el otro día cayó en mis manos un ejemplar de la revista de la IEEE de los años 80 donde hablaban del paralelismo entre memorias y procesadores, lo que hoy vulgarmente llamamos cloud computing. Cuando Internet llegó a nuestras casas ya había pasado la crisis de los cuarenta.

Podríamos remontarnos siglos atrás a hablar de cómo empezó todo, pero hoy me voy a limitar a hablar un poco de algunas figuras importantes del siglo XX.

Alan Turing, el culpable de todo esto

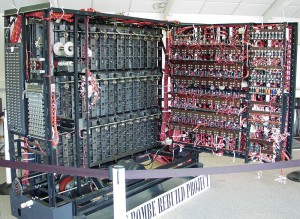

Matemático inglés, padre de la materia, héroe de guerra. Tristemente más célebre por su trágico destino que por sus méritos. Durante la Segunda Guerra Mundial trabajó para el gobierno inglés descifrando los mensajes codificados que los alemanes generaban mediante distintas versiones de la máquina enigma, un dispositivo inventado tras la Primera Guerra Mundial para cifrar mensajes. La labor de Turing durante este tiempo fue decisiva para la victoria de múltiples batallas, y tan necesaria que el propio Winston Churchill dijo que Turing había realizado la mayor contribución a la victoria de los aliados contra los nazis.

Aparte de los más que obvios aportes al criptoanálisis, Turing presentó el primer diseño completo y detallado de un computador de programa almacenado mientras trabajaba en el ACE (Automatic Computing Engine), uno de los primeros computadores con capacidad de hacer llamadas a subrutinas (llamada a función) y que implementaba instrucciones de computación abreviadas (lo que a día de hoy llamamos ensamblador). También diseñó el Test de Turing sobre inteligencia artificial, por el cual toda máquina que intente simular una inteligencia similar a la de un humano debe de ser indistinguible de éste.

La razón por la que popularmente se le conoce, sin embargo, es otra. Ser homosexual en el Reino Unido de los años cincuenta era algo penado por la ley y Turing fue condenado a ser encarcelado o a castrarse químicamente. Eligió lo segundo. Se le acusó de espía (debido a que dos de los cinco de Cambridge eran homosexuales), se le prohibió el acceso a Estados Unidos y se le expulsó de la GCHQ (un organismo de inteligencia británico).

Finalmente en 1954 Alan Turing se quitó la vida con una manzana que previamente había bañado en cianuro.

John von Neumann, desde las trincheras

Si algún día cada rama de la ciencia o de las matemáticas se pusieran a dar las gracias a sus contribuidores, acabarían todas haciendo cola en la tumba de von Neumann. Contemporáneo de Turing pero al otro lado del charco, von Neumann (que se pronuncia «noiman» y no «niuman»), húngaro de nacimiento, fue uno de los principales miembros del Proyecto Manhattan, aquel concebido durante la Segunda Guerra Mundial (vemos que todo converge en el mismo evento) para el desarrollo de la primera bomba atómica.

Von Neumann hizo de todo: topología, geometría, física cuántica, estadística, teoría de juegos… y por supuesto, computación. Antes he comentado que Turing presentó el primer diseño completo y detallado de un computador de programa almacenado, pero fue von Neumann quien realizó el primer borrador. A él le debemos la arquitectura de von Neumann, que describe las partes y sus relaciones de un computador y que sería la base de los computadores posteriores. Leches, a día de hoy seguimos considerando arquitecturas de von Neumann a nuestros PCs (a pesar de que son una evolución de ésta, la premisa es la misma).

Contrario a muchos de los otros miembros del Proyecto Manhattan, él no había sido presionado por sus circunstancias para participar en él, como en el caso de, por ejemplo, Enrico Fermi, creador del primer reactor nuclear, quien huyó de la Italia de Mussolini porque su mujer era judía, o de Niels Bohr, padre del modelo atómico, quien huyó días antes de ser arrestado en Dinamarca. Von Neumann nunca mostró arrepentimiento por ello: él ya trabajaba en defensa antes del proyecto, y continuó haciéndolo tras la guerra. Tan controvertido por sus ideas (durante la Guerra Fría defendió un ataque nuclear preventivo contra la URSS) como excepcional por su conocimiento, murió de cáncer en 1956 custodiado por agentes federales en el hospital que se aseguraban de que la medicación no le invitase a compartir secretos de estado con sus allegados.

Dennis Ritchie y Ken Thompson, héroes anónimos

Cuando Ritchie murió, el 12 de octubre de 2011, fue un día particularmente decepcionante para mí. Principalmente porque no me enteré. No supe nada hasta una semana después cuando leí un artículo sobre cómo la muerte del tío que dejó el mayor legado del siglo veinte había pasado desapercibida para la humanidad. Murió una semana después que Steve Jobs, y el por culo que dieron con ello y las atribuciones que le dieron (las cuales muchas eran mentira o simplemente exageradas) taparon la pérdida de uno de los auténticos padres de la computación.

La contribución de esta pareja de genios es bastante sencilla de enumerar: crearon C. ¿Qué es C? Un lenguaje de programación. ¿Qué se ha hecho en C? Pues la mayoría del software existente se ha hecho en C o en lenguajes derivados de C. C ha supuesto la base de los lenguajes de programación modernos. En C está escrito Windows, en C está escrito Linux, en C está escrito BSD, en C está escrito MacOS.

No sólo eso, sino que con su propio lenguaje de programación crearon UNIX en 1972, el primer sistema operativo moderno de la historia y padre e inspiración de todos los posteriores. Multiusuario y multitarea. Si buscáis información sobre Linux veréis que dice que es un clon de UNIX, y así es: una implementación moderna y compatible de UNIX. Las últimas versiones de MacOS están basadas en NetBSD, que igualmente es un derivado de UNIX. Android funciona sobre Linux. Cuarenta años después seguimos usando tecnología basada en UNIX.

Richard Stallman

Es salirme un poco de la tangente, pero creo que se merece su sitio. No me cae particularmente bien y su discurso me parece que se ha quedado un poco anticuado para los tiempos que corren, pero al César lo que es del César: Stallman nos ha cambiado la forma de mirar el software.

Cuando yo empecé a usar Linux, el software libre era «eso que los perroflautas que quieren todo gratis usan». Los fabricantes de hardware apenas proveían las especificaciones de sus dispositivos (lo que suponía poco soporte en Linux), el aspecto comercial del software libre se tambaleaba. Éramos minoría.

Quién lo diría ahora, que Linux tiene una base de drivers incluso mayor que Windows (que se adolece en las últimas versiones con hardware antiguo). O que nuestro móvil usa un sistema operativo abierto. ¡Estándares abiertos para los dispositivos! El mundo del software libre ha dado un cambio radical en tan sólo una década.

Stallman trabajaba en el MIT donde hasta finales de los años 70 era común obtener el código fuente del software que utilizaba, y que podía modificar y adaptar a sus necesidades. No obstante los fabricantes dejaron de distribuir dicho código con el fin de evitar que se pudiese usar su software en computadores de la competencia.

Las nuevas máquinas y sistemas que llegaron al MIT eran cerradas. Anteriormente había modificado el driver de la impresora para que enviase un mensaje al usuario tras haber imprimido, pero el fabricante de la nueva impresora le denegó acceso al código del driver por lo que no podría hacer lo mismo con ésta, lo cuál no fue del agrado de Stallman ya que la impresora estaba en otra planta. Éste y otros eventos cabrearon tanto a Stallman que en 1984 creo el proyecto GNU, un clon libre de UNIX (quien por la época dominaba el mercado), de forma que los usuarios pudiesen cambiar las versiones propietarias de UNIX por la suya libre.

Mediante la GNU se propagó el mensaje y la necesidad del software libre como filosofía, así como su viabilidad comercial (libre no implica gratuito). Mediante la GNU se desarrollaron herramientas suficientes para tener lo que hoy día llamamos GNU/Linux (Linux no es un sistema operativo, sólo el núcleo; las herramientas básicas del sistema operativo están desarrolladas por GNU). La licencia GPLv2 es la licencia de software libre más extendida la cual garantiza que si un programa es libre, lo seguirá siendo por mucho que se modifique.

A día de hoy no hace falta hablar de la importancia del software libre. Stallman hace muchos años que dejó de ser un científico para ser un filósofo. Quizás no haya sido él la razón por la que el software libre se ha extendido tanto, quizás le debamos esto más a Linus Torvalds (creador de Linux) o a Mark Shuttleworth (creador de Ubuntu, que ha popularizado Linux en el ambiente doméstico) que a él. Pero él puso la semilla y lleva regándola desde hace 30 años.

Borja V. Muñoz

Latest posts by Borja V. Muñoz (see all)

- Los materiales formativos de emprendimiento de YouBrand están listos - 18/12/2019

- Actividad formativa del proyecto Strategies for Digitalising Adult Educationen Lodz, Polonia // Training activity of the Strategies for Digitalising Adult Education Project in Lodz, Poland - 29/05/2019

- Tercer encuentro transnacional del proyecto YouBrand en Atenas, Grecia // Third Transnational Meeting of the YouBrand Project in Athens, Greece - 22/02/2019